RNN 기반의 실시간 수어 인식 및

번역 시스템 연구

청각 장애인의 의사소통 장벽을 허물기 위한 딥러닝 솔루션입니다.

이미지 픽셀 단위가 아닌 Key-point 벡터 분석을 통해 가볍고 빠른 실시간 번역 시스템을 구현했습니다.

[Demo] Real-time Continuous Sign Language Recognition System

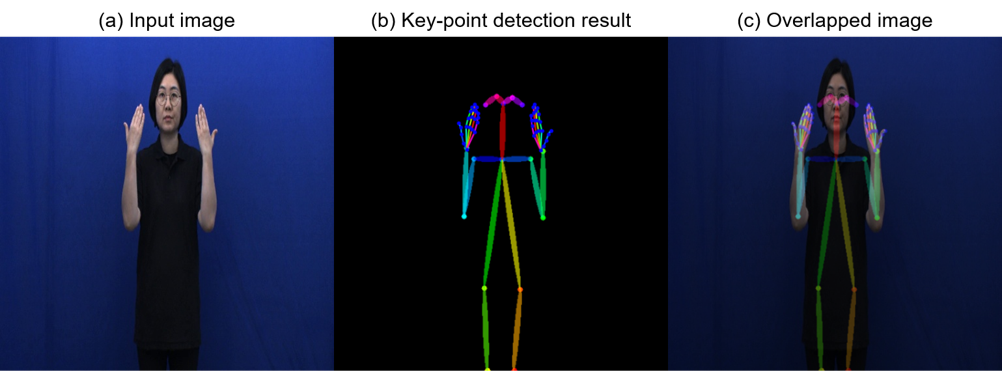

Key-point Detection

RGB 이미지 전체가 아닌 관절의 '좌표(Vector)'만을 추출하여 연산 효율성을 극대화했습니다.

- ✓OpenPose 기반 60개 관절 추출

- ✓배경/조명 노이즈 완벽 제거

- ✓개인별 신체 차이 극복

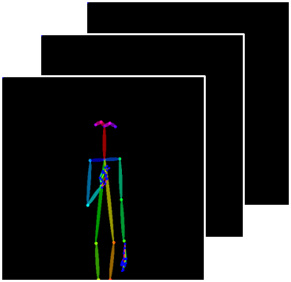

Sequential Analysis

정지된 동작이 아닌 '시간의 흐름'을 분석하기 위해 시계열 데이터를 처리합니다.

- ✓Frame 단위 시퀀스 데이터화

- ✓동작의 시작과 끝점 버퍼링

- ✓연속 동작 문맥 파악

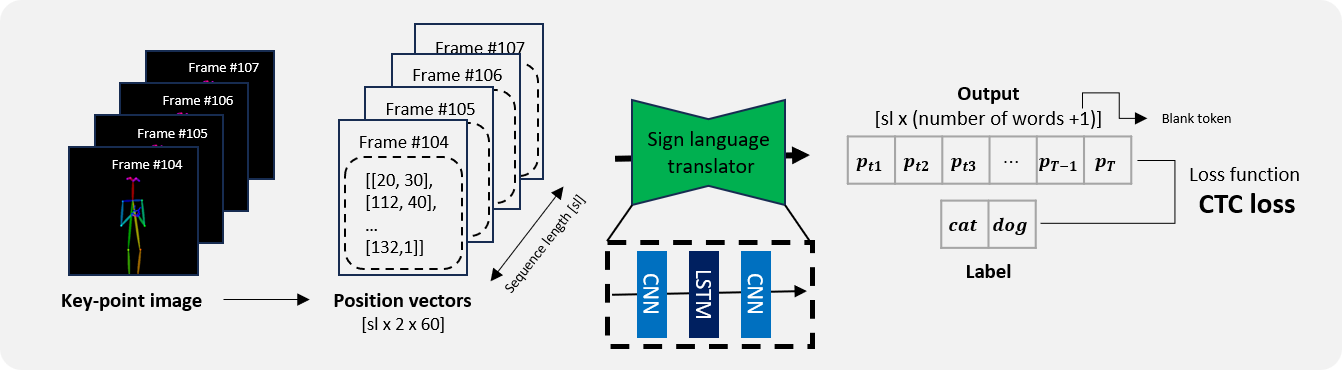

Hybrid Network

공간적 특징(CNN)과 시간적 특징(LSTM)을 결합하여 인식률을 높였습니다.

- ✓Shallow CNN + LSTM 구조

- ✓CTC Loss 기반 학습

- ✓Beam Search 최적화

좌표 기반의 특징 추출

영상 데이터를 그대로 학습하면 배경이나 옷차림 같은 노이즈(Noise)에 크게 영향을 받습니다.

우리는 OpenPose를 사용하여 신체의 60개 주요 관절 포인트(Body 18 + Hand 42)만을 정밀하게 추출합니다. 이를 통해 데이터 크기를 획기적으로 줄이고, 연산 속도를 높였습니다.

- 입력 이미지(Input Image)에서 배경 제거 효과

- (x, y) 좌표 벡터로 변환하여 연산량 최소화

- Data Augmentation (Clipping, Shifting) 적용

시계열 동작 분석

수어는 정지된 이미지가 아닌 연속된 동작의 흐름입니다.

추출된 스켈레톤 데이터를 프레임 단위의 시퀀스(Sequence)로 변환하여 시간의 흐름에 따른 손의 위치 변화와 움직임의 궤적을 추적합니다.

- 프레임별 스켈레톤 좌표 추적

- 동작의 시작과 끝을 인식하기 위한 Buffer 적용

- 연속된 프레임 데이터를 하나의 텐서로 변환

Shallow CNN + LSTM

공간적 특징을 추출하는 CNN과 시간적 맥락을 파악하는 LSTM을 결합했습니다.

이 하이브리드 구조는 손 모양의 미세한 특징과 동작의 순서를 동시에 학습하여 높은 인식 정확도를 제공합니다.

- Input: [Sequence Length x 2 x 60] 벡터

- Output: 51개 클래스(단어 + Blank) 확률값

- Loss Function: CTC Loss (가변 길이 시퀀스 처리)

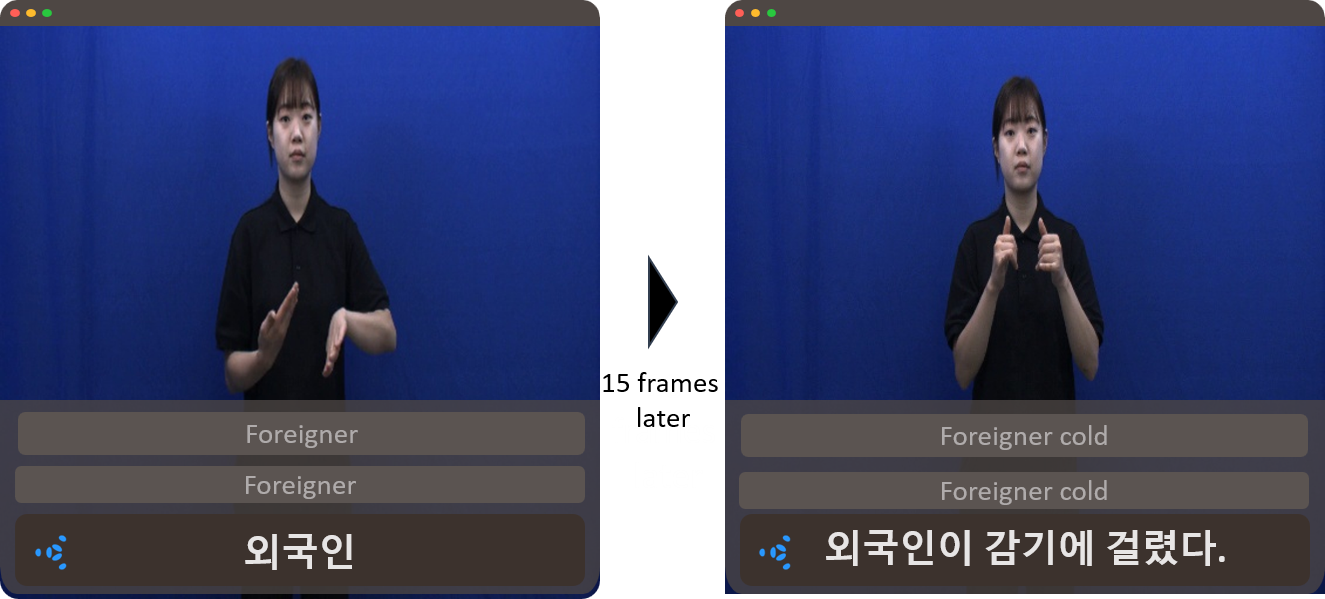

자연어 문장 완성

단순한 단어 나열이 아닙니다. CTC Decoder와 Beam Search를 통해 가장 문맥에 적합한 자연어 문장을 완성합니다.

실시간 버퍼링을 통해 입력 지연 없이 끊김 없는 번역 결과를 제공합니다.

- "Foreigner" + "Cold" → "외국인이 감기에 걸렸다"

- 이전 문맥을 기억하여 오인식 보정

- 실시간 스트리밍 환경에서도 안정적인 성능

Original Publication

본 프로젝트의 기반이 된 연구 논문입니다.

RNN 기반 수어 인식 기술의 구체적인 알고리즘과 실험 결과를 확인하실 수 있습니다.

Real-time Sign Language Recognition using RNN-based Network

This project aims to develop a real-time sign language recognition system specifically for Korean Sign Language (KSL) using Recurrent Neural Network (RNN)-based models. Leveraging advancements in computer vision and NLP, we propose a solution that converts sign language videos into key points using the OpenPose library...

기술이 사회적 가치를 만날 때,

우리는 더 나은 내일을 꿈꿉니다.

© 2025 AI Sign Language Project. All rights reserved.